李飞飞团队AI视频生成模型介绍_扩散模型W.A.L.T

视频大数据时代,真的来了!

刚刚,李飞飞的斯坦福团队同谷歌合作,推出了用于生成逼真视频的扩散模型W.A.L.T。

这是一个在共享潜在空间中训练图像和视频生成的,基于Transformer的扩散模型。

论文:https://walt-video-diffusion.github.io/assets/W.A.L.T.pdf

英伟达高级科学家Jim Fan转发评论道:2022年是影像之年,2023是声波之年,而2024.是视频之年!

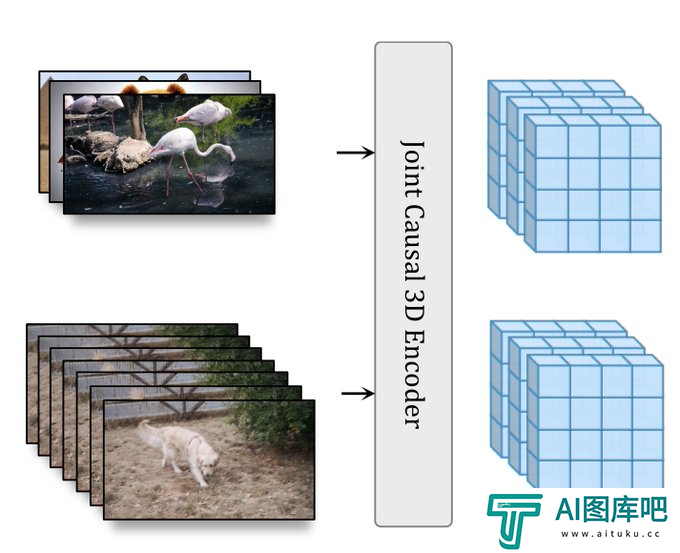

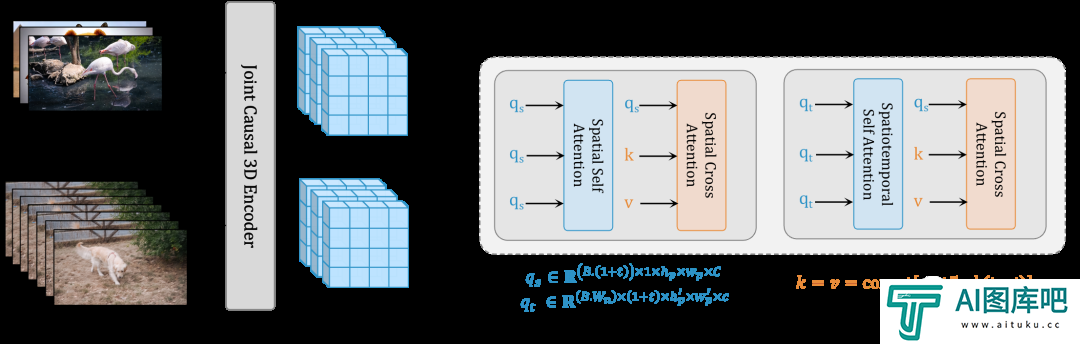

首先,研究人员使用因果编码器在共享潜在空间中压缩图像和视频。

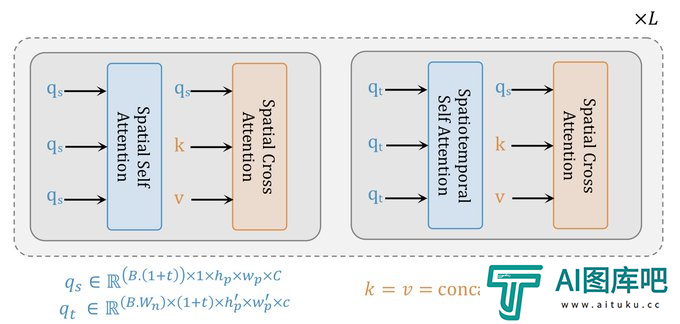

其次,为了提高记忆和训练效率,研究人员使用基于窗口注意力的Transformer架构来进行潜在空间中的联合空间和时间生成建模。

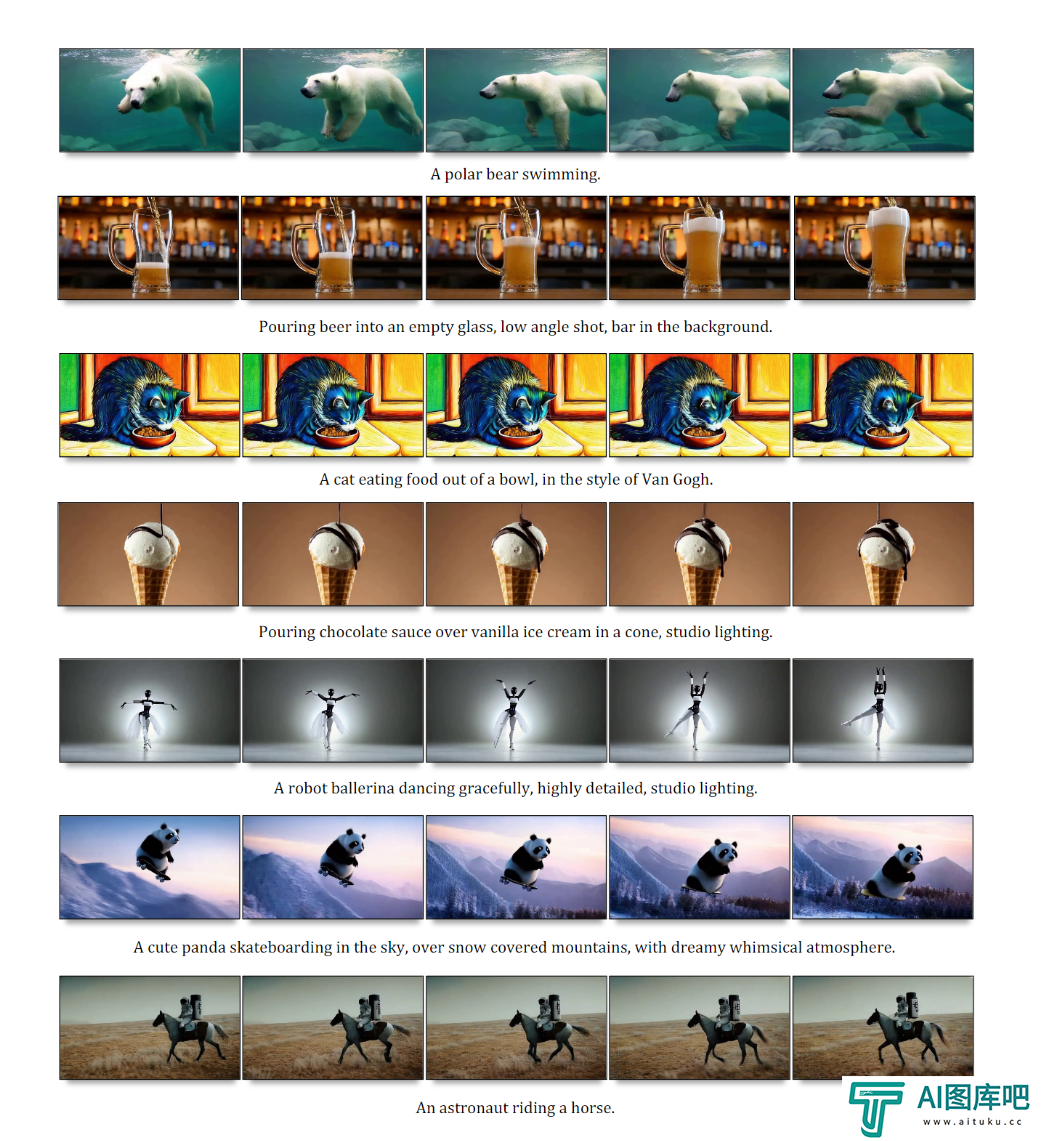

研究人员的模型可以根据自然语言提示生成逼真的、时间一致的运动:

A Teddy bear skating carefully in Times Square,Slow Motion/一只泰迪熊在时代广场上优雅的滑冰,慢动作

Pouring chocolate sauce over vanilla ice cream in a cone, studio lighting/将巧克力酱倒在香草冰淇淋甜筒上,工作室灯光

An stronaust riding a horse/一名宇航员骑着马

A squirrel eating a burger/一只松鼠在吃汉堡

A panda taking a selfie/一只正在自拍的熊猫

An elephant wearing a birthday hat walking on the beach/一头戴着生日帽的大象在海滩上行走

Sea lion admiring nature, river, waterfull, sun, forest/海狮欣赏自然,河流,瀑布,阳光,森林

Pouring latte art into a silver cup with a golden spoon next to it/在银杯中进行拿铁拉花,旁边放着金勺子

Two knights dueling with lightsabers,cinematic action shot,extremely slow motion/两个骑士用光剑决斗,电影动作镜头,极其慢动作

A swarm of bees flying around their hive/一群蜜蜂在他们的蜂巢周围飞翔

这个结构还可以用图片生成视频:

A giant dragon sitting in a snow covered landscape, breathing fire/一条巨大的龙盘踞在冰雪覆盖的大地上,喷吐着火焰

A cute panda skateboarding in the sky, over snow covered mountains, with a dreamy and whimsical atmosphere/一只可爱的熊猫在天空中滑滑板,越过雪山,充满梦幻和异想天开的气氛

An asteroid collides with Earth, massive explosive, slow motion/小行星撞上地球,大规模爆炸,慢动作

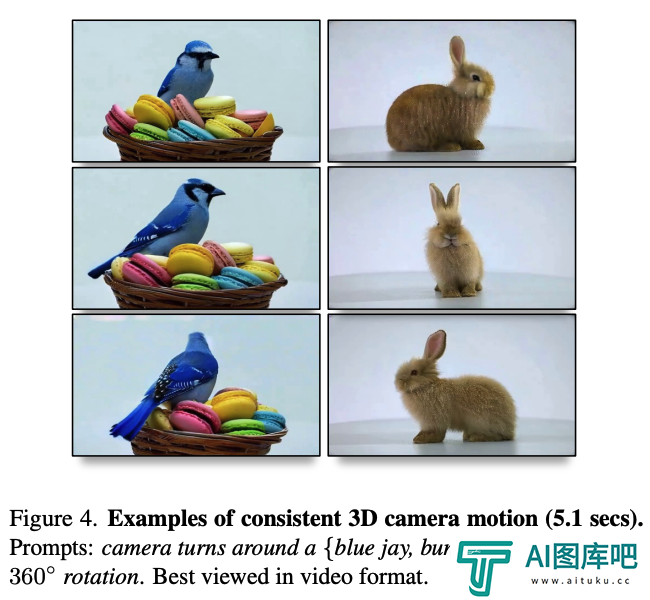

以及,生成一致性很高的3D相机运动的视频。

Cameraturns around a cute bunny, studio lighting, 360 rotation/相机围绕一只可爱的兔子旋转,工作室灯光,360度旋转

Camera turns around utah teapot,studio lighting,360 rotation/相机围绕茶壶旋转,工作室灯光,360度旋转

Camera turns around a burger on a plate,studio lighting,360 rotation/相机围绕盘子中的汉堡旋转,工作室灯光,360度旋转

网友们惊叹道,这些天好像已经人手一个LLM或者图像生成器。

今年简直是AI发展的煽动性的一年。

两个关键决策,组成三模型级联

W.A.L.T的方法有两个关键决策。

首先,研究者使用因果编码器在统一的潜在空间内联合压缩图像和视频,从而实现跨模态的训练和生成。

其次,为了提高记忆和训练效率,研究者使用了为空间和时空联合生成建模量身定制的窗口注意力架构。

通过这两个关键决策,团队在已建立的视频(UCF-101 和 Kinetics-600)和图像(ImageNet)生成基准测试上实现了SOTA,而无需使用无分类器指导。

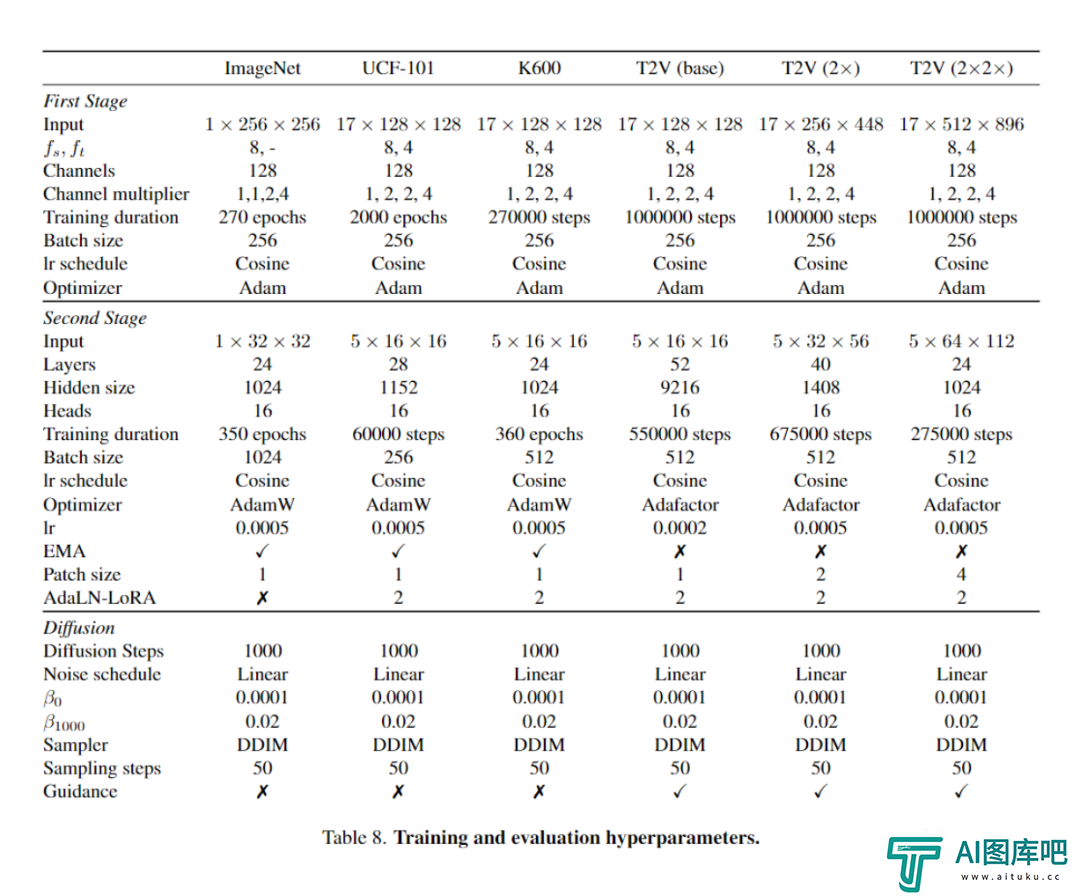

最后,团队还训练了三个模型的级联,用于文本到视频的生成任务,包括一个基本的潜在视频扩散模型和两个视频超分辨率扩散模型,以每秒8帧的速度,生成512 x 896分辨率的视频。

W.A.L.T的关键,是将图像和视频编码到一个共享的潜在空间中。

Transformer主干通过具有两层窗口限制注意力的块来处理这些潜在空间——空间层捕捉图像和视频中的空间关系,而时空层模拟视频中的时间动态,并通过身份注意力掩码传递图像。

而文本调节,是通过空间交叉注意完成的。

W.A.L.T解决视频生成建模难题

Transformer是高度可扩展和可并行的神经网络架构,是目前最当红的构架。

这种理想的特性也让研究界越来越青睐Transformer,而不是语言 、音频、语音、视觉、机器人技术等不同领域的特定领域架构。

这种统一的趋势,使研究人员能够共享不同传统领域的进步,这样就造就了有利于Transformer的模型设计创新和改进的良性循环。

然而,有一个例外,就是视频的生成建模。

扩散模型已成为图像和视频生成建模的领先范例。然而,由一系列卷积层和自注意力层组成的U-Net架构一直是所有视频扩散方法的主流。

这种偏好源于这样一个事实:Transformer中完全注意力机制的记忆需求,与输入序列的长度呈二次方缩放。

在处理视频等高维信号时,这种缩放会导致成本过高。

潜在扩散模型可以通过在从自动编码器派生的低维潜在空间中运行,来降低计算要求。

在这种情况下,一个关键的设计选择,就是所使用的潜在空间的类型:空间压缩 (每帧潜在) 与时空压缩。

空间压缩通常是首选,因为它可以利用预训练的图像自动编码器和LDM,它们在大型成对图像文本数据集上进行训练。

然而,这种选择增加了网络复杂性,并限制了Transformer作为骨干网的使用,尤其是由于内存限制而生成高分辨率视频时。

另一方面,虽然时空压缩可以缓解这些问题,但它排除了配对图像文本数据集的使用,后者比视频数据集更大、更多样化。

因此,研究者提出了窗口注意力潜在Transformer (W.A.L.T) :一种基于Transformer的潜在视频扩散模型 (LVDM) 方法。

该方法由两个阶段组成。

首先,自动编码器将视频和图像映射到统一的低维潜在空间中。这种设计能够在图像和视频数据集上联合训练单个生成模型,并显著减少生成高分辨率视频的计算负担。

随后,研究者提出了一种用于潜在视频扩散建模的Transformer块的新设计,由在非重叠、窗口限制的空间和时空注意力之间交替的自注意力层组成。

这种设计有两个主要好处——

首先,使用局部窗口注意力,可以显著降低计算需求。

其次,它有利于联合训练,其中空间层独立处理图像和视频帧,而时空层致力于对视频中的时间关系进行建模。

虽然概念上很简单,但团队的方法让Transformer在公共基准上潜在视频传播中表现出了卓越的质量和参数效率,这是第一个经验证据。

具体来说,在类条件视频生成 (UCF-101) 、帧预测 (Kinetics-600) 和类条件图像生成 (ImageNet)上, 不使用无分类指导,就取得了SOTA。

最后,为了证明这种方法的可扩展性和效率,研究者还生成了逼真的文本到视频生成效果。

他们训练了由一个基本潜在视频扩散模型和两个视频超分辨率扩散模型组成的级联模型,以每秒8帧的速度生成512X896分辨率的视频,并且在UCF-101基准测试中,取得了SOTA的zero-shot FVC分数。

学习视觉符号

视频生成建模中的一个关键设计决策,就是潜在空间表征的选择。

理想情况下,需要一个共享且统一的压缩视觉表征,可用于图像和视频的生成建模。

统一的表征很重要,这是因为由于标记视频数据(例如文本视频对)的稀缺,联合的图像-视频学习更可取。

为了实现视频和静态图像的统一表征,第一帧始终独立于视频的其余部分进行编码。

为了将这个设计实例化,研究者使用了MAGVIT-v2分词器的因果3DCNN编码器-解码器。

通常,编码器-解码器由常规D卷积层组成,它们无法独立处理第一帧。

而因果3D卷积层解决了这个问题,因为卷积核仅对过去的帧进行操作。

这就确保了每个帧的输出仅受前面帧的影响,从而使模型能够独立标记第一帧。

实验

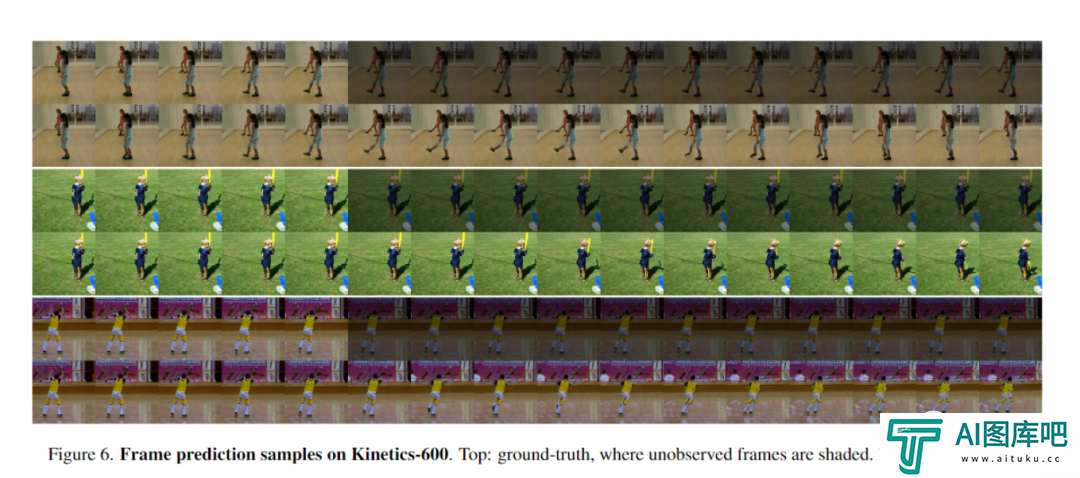

视频生成

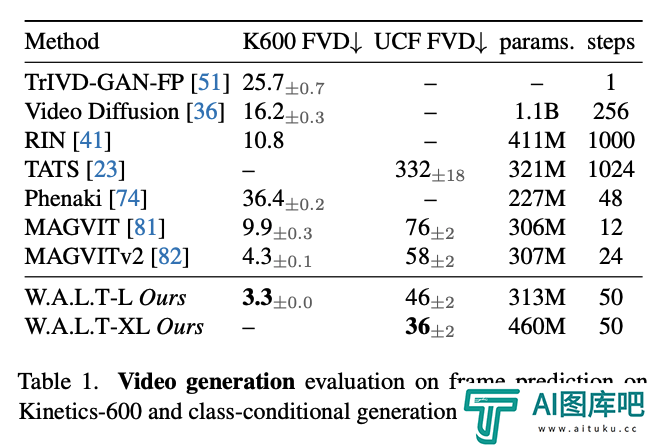

研究人员考虑了两个标准视频基准,即类别条件生成的UCF-101和带有5个条件帧的视频预测Kinetics-600.

研究人员使用FVD 作为主要评估指标。在这两个数据集上,W.A.L.T 显著优于之前的所有工作(下表1)。

与之前的视频扩散模型相比,研究人员在模型参数更少的情况下实现了最先进的性能,并且需要50个DDIM推理步骤。

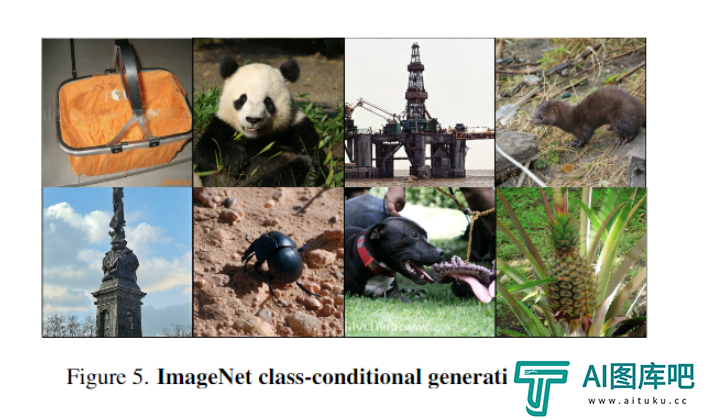

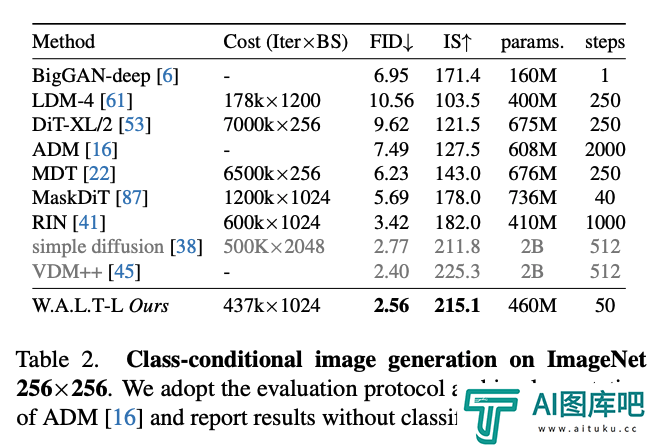

图像生成

为了验证W.A.L.T在图像领域的建模能力,研究人员训练了一个W.A.L.T版本,用于标准的ImageNet类别条件设置。

在评估中,研究人员遵循ADM并报告在50K样本上用50个DDIM步骤生成的FID和Inception分数。

研究人员将W.A.L.T与256 × 256分辨率的最先进图像生成方法进行比较(下表2)。研究人员的模型在不需要专门的调度、卷积归纳偏见、改进的扩散损失和无分类器指导的情况下优于之前的工作。尽管VDM++的FID分数略有提高,但该模型的参数明显更多(2B)。

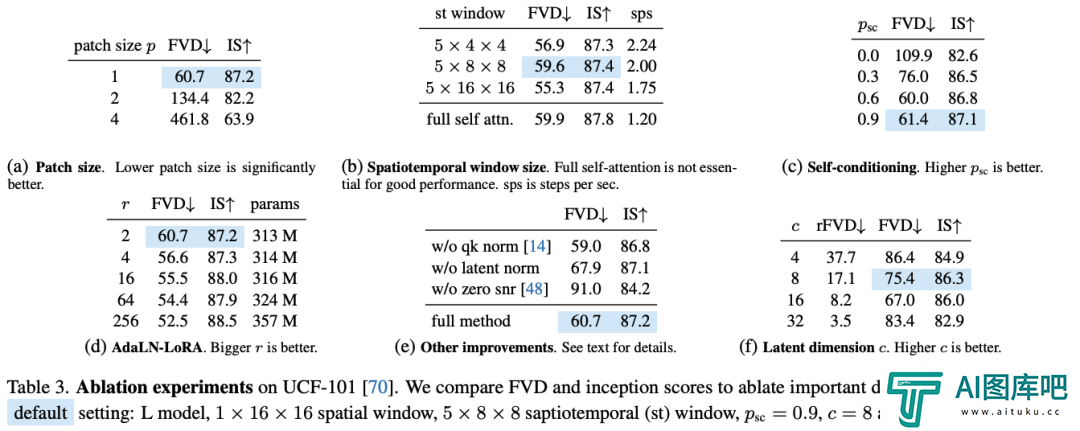

消融实验

在使用ViT -based模型的各种计算机视觉任务中,已经证明较小的补丁大小p可以始终提高性能。同样,研究人员的研究结果也表明,减小补丁大小可以提高性能(下表3a)。

窗口注意力

研究人员比较了三种不同的STW窗口配置与全自注意(表3b)。研究人员发现,局部自注意力可以在速度上显著更快(高达2倍)并且减少加速器内存的需求,同时达到有竞争力(或更好)的性能。

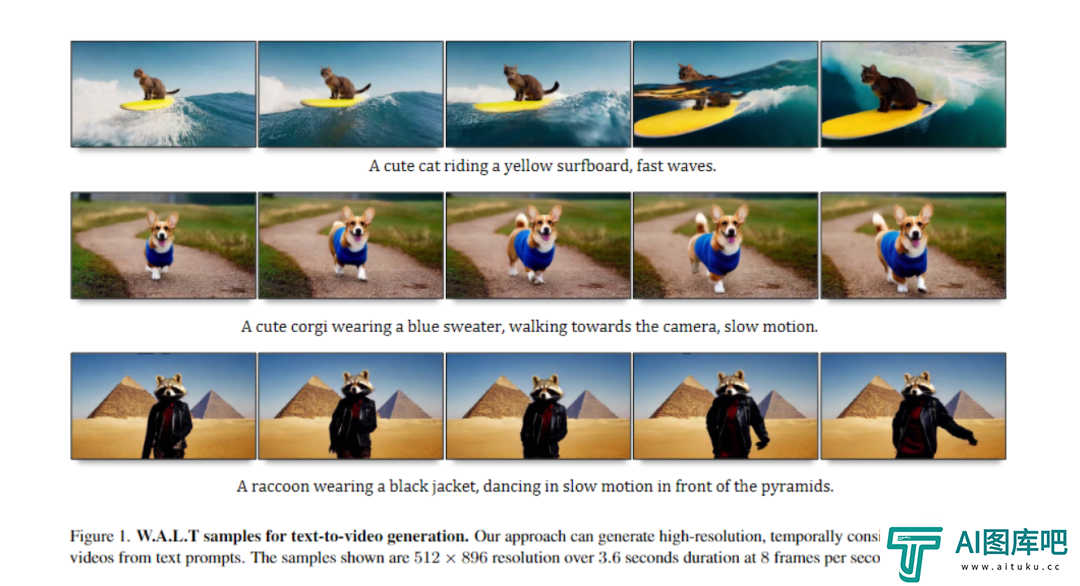

文生视频

研究者在文本-图像和文本-视频对上,联合训练了文本到视频的W.A.L.T。

使用的是来自公共互联网和内部来源的约970M文本-图像对,和约89M文本-视频对的数据集。

定性评估

W.A.L.T根据自然语言提示生成的示例视频,分辨率为512*896.持续时间为3.6秒,每秒8帧。

W.A.L.T模型能够生成与文本提示一致、时间一致的逼真视频。

研究人员在以1或2个潜在帧为条件的帧预测任务上,联合训练了模型。

因此,模型可用于图像动画(图像到视频)和生成具有连贯镜头运动的较长视频。

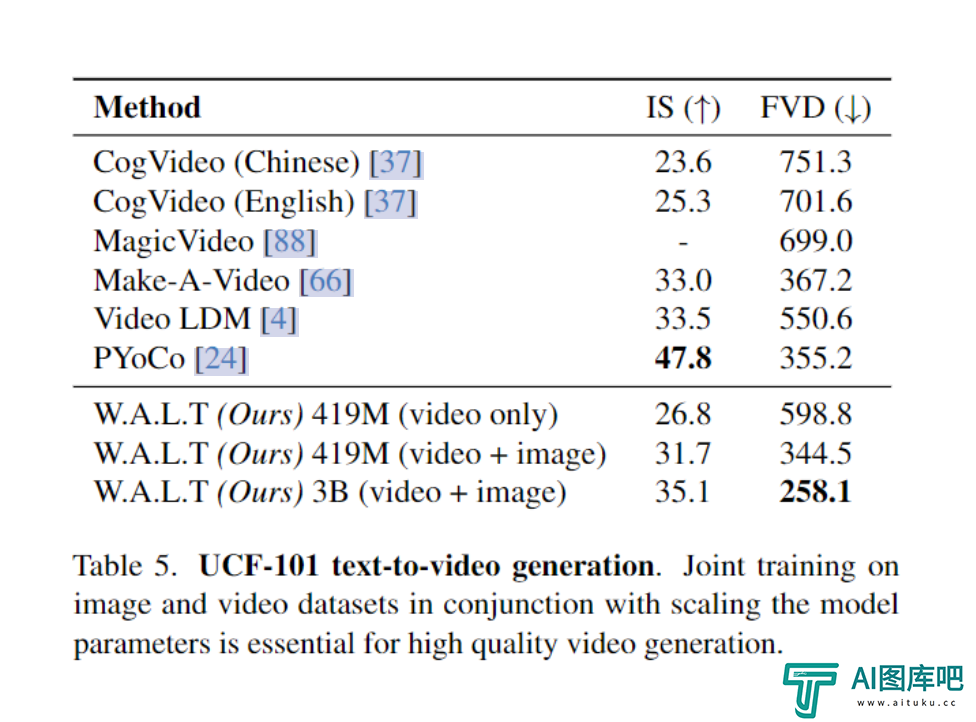

定量评价

科学地评估文本条件视频生成系统仍然是一个重大挑战,部分原因是缺乏标准化的训练数据集和基准。

到目前为止,研究人员的实验和分析主要集中在标准学术基准上,这些基准使用相同的训练数据来确保受控和公平的比较。

尽管如此,为了与之前的文本到视频工作进行比较,研究人员还在表 5 中的零样本评估协议中报告了 UCF-101 数据集的结果。

研究人员框架的主要优势是它能够同时在图像和视频数据集上进行训练。

在上表5中,研究人员消除了这种联合训练方法的影响。

具体来说,研究人员使用第5.2 节中指定的默认设置训练了两个版本的W.A.L.T-L (每个版本有 419M 参数)模型。

研究人员发现联合培训可以使这两个指标都有显著改善。

-

李飞飞团队AI视频生成模型介绍_扩散模型W.A.L.T

视频大数据时代,真的来了!刚刚,李飞飞的斯坦福团队同谷歌合作,推出了用于生成逼真视频的扩散模型W A L T。这是一个在共享潜在空间中训练图像和视频生成的,基于Transformer的扩散模型。

2025-04-28 18:55:54 -

张旭代表:把北京建设成人工智能赋能科学研究的全球中心城市

1月14日至18日,北京市第十六届人民代表大会第三次会议举行。北京市人大代表、十四届全国政协提案委员会委员,九三学社中央副秘书长张旭在现场接受新京报记者采访时表示,他本次上会,带来了关于建设人工智能赋能

2025-04-28 18:51:19 -

Soul发布AI聊天机器人“苟蛋”丨李飞飞团队×谷歌发布视频生成大模型W.A.L.T丨Runway研发AI视频“通用世界模型”

【AI奇点网2023年12月13日早报】本站每日播报AI业界最新资讯,触摸时代脉搏,掌握未来科技动向。事不宜迟,点击查看今日AI资讯早餐。

2025-04-28 18:31:21 -

两会·新质观察团|寻找2025年人工智能应用掘金点

“北京市是国内人工智能发展的策源地,人工智能浪潮仍处于初始阶段,后续还有许多应用,具身智能将成为人工智能大模型下一个发展路径”,近日,北京市经信局党组成员、副局长唐建国给北京人工智能发展划下方向。

2025-04-28 18:28:46 -

阿里AI视频生成模型DreaMoving_人脸图+提示词就能让纸片人动感起舞,随心生成服装与背景

阿里又整活了!阿里巴巴AI团队最新的一项AI视频生成研究课题——项目名称叫「DreaMoving」,主打的就是让任何人、随时且随地地跳舞。

2025-04-28 18:06:27 -

2025委员通道丨李涛:让人工智能跑出“河南加速度”

大河网讯 输入一段文字,就能生成一个短视频……如今,人工智能已经全面融入人们的生活。 作为一项引领未来的战略性技术,人工智能是引领这一轮科技革命和产业变革的战略性技术,具有溢出带动性很强的‘头雁’效应。2

2025-04-28 18:04:22

-

AI绘画ComfyUI进阶教程丨如何实现Clip精准控图,流程自动化入门!

大家好,又到学习时刻? 本期跟大家分享CLIP构图相关的一些进阶基础内容,以及自动化逻辑编程基础,希望能对大家有所启发,最后不要忘记支持欧阳一波啦?!

2024-12-17 13:16:14 -

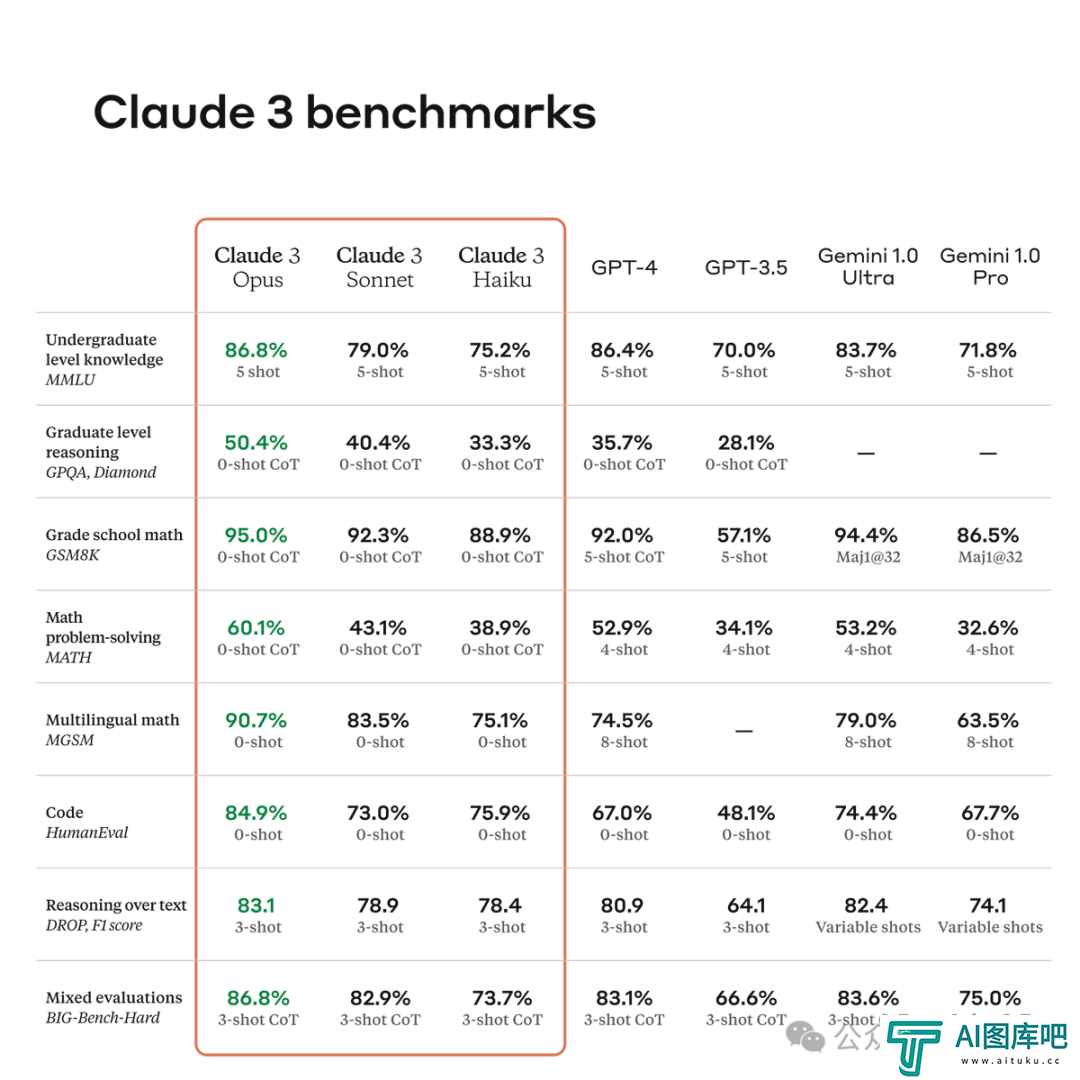

大语言模型「新王」Claude 3全面测评:原生多模态大模型各项能力实力超群,连打麻将都学会,实测比GPT-4好用

OpenAI「不可战胜」的神话,看样子是要被打破了。Claude 3的多版本发布后,“中杯”Sonnet直接免费体验,“大杯”Opus充个会员也能即刻享受,各路测评纷至沓来。

2024-12-13 18:57:45 -

阿里旗下夸克APP上线“AI学习助手”:内置海量试题,拍照一键解疑,巧用大模型帮助当代学子高效备考、快速进阶

夸克“AI学习助手”采用夸克宝宝的虚拟形象为用户进行题目讲解。基于大语言模型和视觉技术,AI智能讲解能够给用户提供 “考点分析”、“详解步骤”、“答案总结”等详细内容。

2025-02-18 16:08:16 -

Music To Image音生图工具是什么_AI音频生成图像工具有哪些_AI音生图工具有哪些_Music To Image怎么用

「Music To Image」是一款AI音频生成图片的多模态转换工具,它的本质生成逻辑是音频→文本提示词→图像。

2024-12-17 00:06:33 -

ChatGPT怎么本地登录_GPT怎么使用_GPT本地项目

本期就ChatGPT的这次更新再次将完全新人使用指南提上日程,并对此次更新做些设想和想象。希望大家喜欢!

2024-12-19 07:41:20 -

Stable Diffusion怎么控制表情_AI绘画局部修改表情怎么做_AI绘画局部控制表情教程

给大家带来了一个超级实用的Stable Diffuison绘画小技巧,就是如何用我们之前提到的After Detailer插件来控制生成人像图片的人物表情!

2024-12-24 17:31:46 -

钉钉发布V7.5版本:首次推出AI个人助理产品「超级助理」,人人都可以创建专属的AI助理并上架应用市场

钉钉举行V7 5版本的迭代产品发布会,钉钉正式发布了基于70万家企业需求共创的AI助理产品,推动AI的使用门槛进一步降低,让人人都能创造AI助理。

2025-02-19 14:21:28 -

陆洪磊、陆庆悠:打破AI谣言“黑箱”,需要社会共治

前段时间的日喀则地震牵动了全国人民的心,一组“小男孩被埋”的图片也引发广泛关注。然而经警方查证,这组图片实为人工智能(AI)工具创作,原图发布于2024年11月,在地震发生后被造谣者利用。 无独有偶,美国加州

2025-02-27 17:42:13 -

网易有道云笔记推出AI助手,帮你一键写文章列大纲,轻松改写重写

网易有道云笔记日前更新7 2 6最新版,新增了AI助手的新版块,AI 助手支持头脑风暴、写文章、写大纲、列待办事项等操作。

2025-04-08 16:22:58 -

AI绘画ComfyUI进阶教程丨插件IPAdapter的详细使用教程,风格模仿,换脸全靠它

哈咯大家好,本期正式给大家带来进阶部分的插件讲解教程,虽然很多朋友一直在用IPA但可能很多朋友还不太了解其结构,希望这期关于ipa用法的教程能对大家有所帮助吧!

2024-12-17 22:49:30