ControlNet是什么_ ControlNet 有什么用

AI奇点网工具使用教程丨Stable Diffusion 使用教程系列

ControlNet 按照骨架动作绘图

ControlNet是通过加入额外条件来控制扩散模型的神经网络结构,它可以让AI参考给定图片的动作/线条/景深,更精准的生成图片。

跟内置的「图生图」技术比起来,ControlNet的效果更好,能让AI以指定动作生图;再搭配3D建模作为辅助,能缓解单纯用文生图手脚、脸部表情画不好的问题。

ControlNet的用法还有:上传人体骨架线条,ControlNet就能按骨架的动作生成完稿的人物图片。或是上传素色的3D建模,让ControlNet彩现成为室内布置家具。

Lvmin Zhang是ControlNet原始程序的开发者,Mikubill则是开发扩充功能,让我们可以在Stable Diffusion WebUI用ControlNet生图。

扩充功能来源: Mikubill/sd-webui-controlnet

ControlNet的保存库: lllyasviel/ControlNet

安装ControlNet与下载模型

1.切换至Extensions页面,点击Install From URL,URL输入https://github.com/Mikubill/sd-webui-controlnet.git,按下Install,接着从终端机按CTRL+C,关闭Stable Diffusion WebUI。

2.到 lllyasviel/ControlNet v1.1下载以.pth结尾的模型档,全部文件加起来约18GB。.yaml档不需要下载。目前v1.1是测试版,之后会合并回 主保存库。

3.将这些模型档放到 stable-diffusion-webui/extensions/sd-webui-controlnet/models 文件夹

4.重新启动 Stable Diffusion WebUI。

各个模型的用途

ControlNet现有以下模型,您可以按照需求只下载需要的模型。

Anime Lineart

侦测线条,生成的图片亦会保留原始的线条,适合处理动漫图像

Canny

侦测图片边缘,比较模糊,不如Scribbles完整。

Depth

侦测输入图片的深度图(depth map)。

Illumination

侦测输入图片的光源与照明效果。

Inpaint

功能类似「内补绘制」,使用50%随机遮罩+50%随机光流遮罩训练而成。

Instruct Pix2Pix

模型文件名为ip2p,类似「图生图」,但是使用训练50%的指示(instruction)提示词和50%的叙述(description)提示词训练而成。因为是ControlNet,使用此模型时不需要调整CFG Scale。

根据原作者的说法,此模型在下「使其成为X」的提示词所生成的图,效果比「使Y成为X」要好。

Also, it seems that instructions like “make it into X” works better than “make Y into X”.

Lineart

侦测线条,适合处理线稿,生成的图片亦会保留原始的线条。

M-LSD

侦测输入图片的直线。

Normalbae

Openpose

使用OpenPose技术侦测输入图片人物的动作,不一定会保留线条。

Scribbles

侦测线条,侦测到的线条品质介于Soft Edge和Lineart之间。

Segmentation

模型文件名为seg,将侦测的图片对象切成一个一个色块处理,例如房子一个色块,后面的天空一个色块。

Shuffle

把输入图片的概念转移到生成的图片。

作者给的例子:输入灰色装甲图片,生成的钢铁人盔甲也会是灰色的。

Soft Edge

侦测图片边缘,效果较为柔和,像用炭笔涂过。

Tile

输入图片,选取一个区域,使其变清晰的模型。

参数解说

在安装之后,WebUI的界面会多出"ControlNet"的按钮。

点开会看到以下选项:

Single Image

上传单张图片。

Batch

处理多张图片。Input Directory填写的是待处理的图片所在路径。

Open New Canvas

清除图片,开一张新画布。

使用电脑镜头

在Open New Canvas的选项下面有四个按钮。

由左到右:添加画布;使用电脑镜头拍照上传;未知;还原上次算图设置。

Enable

在生图时激活ControlNet,必选。

Low VRAM

生图使用ControlNet会吃更多VRAM,此选项可降低VRAM使用量。

Pixel Perfect

由ControlNet自动决定Preprocessor分辨率。

Allow Preview

允许预览生图结果,会显示该模型侦测的线条或骨架。

Preprocessor 预处理器

通常Preprocessor和Model二者要一致。

Preprocessor是先将上传的图片处理过一轮,例如Scribbles会将彩色图片转成线稿。若图片的线条是白底黑线,且不是用WebUI画布所绘制,则Preprocessor必须选取"Invert"。

如果你的图片不需要处理,Preprocessor可留空。

Run Preprocessor (爆炸图标)

运行预处理器,预先处理图片。

Model 模型

设置生图的时候使用哪个ControlNet模型。

Control Weight

ControlNet在生图时的权重。

Starting Control Step

要让ControlNet开始参与生图的步数。

Ending Control Step

让ControlNet结束参与生图的步数。

Preprocessor Resolution

预处理器的分辨率。

如果不知道要设多少,请勾选"Pixel Perfect"让ControlNet自动为您决定。

Control Mode (Guess Mode)

控制生图时,要AI平衡二者(Balanced),或是偏重你的提示词(My prompt is more important),还是偏重ControlNet (ControlNet is more important)。

[Loopback] Automatically send generated images to this ControlNet unit

自动将生成的图片传回此ControlNet运算单元(unit)。

是的,如果您的电脑VRAM够大,您可以在Settings → ControlNet激活多个ControlNet运算单元。

Multi ControlNet

一个ControlNet效果不够,您有没有想过激活第二、第三个ControlNet!?

缺省安装后只会使用一个ControlNet,但是叠加多个有助于生成更好的图片。比方说同时使用Open Pose和Depth生成人体,并防止手画歪。

要激活Multi ControlNet,请进入Settings → ControlNet,拖动拉杆,设置要激活的ControlNet数量。

实际操作

此处以改绘一个人物姿势为例子。

1.在安装之后,WebUI的界面会多出"ControlNet"的按钮。

2.进入文生图的页面填入提示词,接着点开下面ControlNet的界面,勾选Enabled激活ControlNet,上传图片。勾选LowVRAM可降低VRAM占用。

3.接着选取要使用的Preprocessor和Model,二者要一致。

Preprocessor是先将上传的图片处理过一轮,例如Scribbles会将彩色图片转成线稿。如果你的图片不需要处理,则Preprocessor可留空。

4.以Scribbles为例,选取后点击右上角Generate即会生成出结果,并附上侦测到的线条。如下图所示,右边贞德的姿势确实跟左边的02十分类似。

-

小度全新AI硬件将于百度世界大会发布丨智谱AI、即梦AI上线新一代视频生成模型丨OpenAI安全系统团队负责人离职

【AI奇点网2024年11月11日早报】本站每日播报AI业界最新资讯,触摸时代脉搏,掌握未来科技动向。事不宜迟,点击查看今日AI资讯早餐。

2025-01-08 11:46:33 -

字节跳动内测豆包通用图像编辑模型SeedEdit丨Grok聊天机器人免费版内测丨月之暗面Kimi创始人被提起仲裁

【AI奇点网2024年11月12日早报】本站每日播报AI业界最新资讯,触摸时代脉搏,掌握未来科技动向。事不宜迟,点击查看今日AI资讯早餐。

2025-01-08 11:25:01 -

李彦宏:文心大模型日调用量超15亿丨百度发布文心「iRAG」文生图技术丨小度AI智能眼镜发布,搭载大模型边走边问

【AI奇点网2024年11月13日早报】本站每日播报AI业界最新资讯,触摸时代脉搏,掌握未来科技动向。事不宜迟,点击查看今日AI资讯早餐。

2025-01-08 10:58:46 -

巧妙利用这两个AI产品,让你的国庆出行没有废片

这两天就有朋友来问我,有没有那种能修图的AI,就是扩图+消除啥的傻瓜好用的。大家大概的需求总结一下其实就两,AI消除+AI扩图。

2025-01-08 10:34:49 -

OpenAI初步谈妥融资70亿美元:最大金主微软追加投资10亿,苹果退出

据华尔街日报报道,苹果公司退出了对 OpenAI 的新一轮融资谈判,而微软则计划向 OpenAI 追加约 10 亿美元的投资。

2025-01-08 10:14:21 -

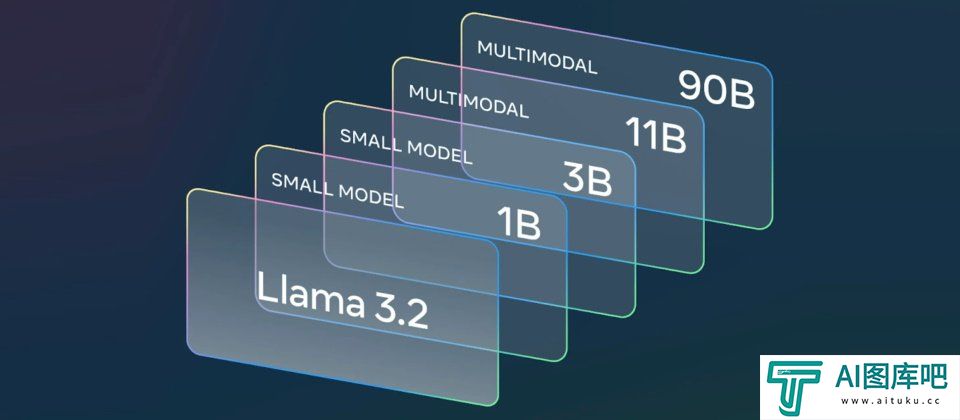

详解Meta全新大模型Llama 3.2系列:多模态视觉识别能力媲美OpenAI GPT-4o

Meta公司推出了Llama 3 2,也是它首款能够理解图像和文本的旗舰视觉模型。包含中型和小型两个版本,以及更轻量化可用于手机端侧的纯文本模型。

2025-01-08 09:46:43

-

怎么快速给模特换装_怎么用stable diffusion给模特换装

本篇教程主要运用StableDiffusion这个工具来进行操作,下面会通过几个小案例,给大家展示不同需求下,我们该如何使用StableDiffusion来辅助我们完成服装效果展示。本教程适用于电商设计场景、摄影场景等多个运用人物设计的实战中

2024-12-23 13:57:15 -

万万没想到,兵马俑都开始跳「科目三」:阿里云通义千问APP打造“全民舞王”视频创作工具,实测效果大赞

兵马俑跳《科目三》,是我万万没想到的。有人借助了阿里云之前走红的AI视频生成技术——「Animate Anyone」,生成出来了这个舞蹈片段。

2024-12-13 16:46:26 -

AIGC落地实践!四招帮你快速搞定运营设计

回顾这一年,随着 AIGC 浪潮的爆发,在掌握AI工具已经成为设计师必备技能。今天这篇文章,通过三个案例流程拆解带大家从新时代设计工作流,到必备「四大招式」,到图标设计六大方向,到训练专属模型,再到全流程手把手拆解设计项目,绝对干货满满

2024-12-18 16:57:17 -

ChatGPT怎么本地登录_GPT怎么使用_GPT本地项目

本期就ChatGPT的这次更新再次将完全新人使用指南提上日程,并对此次更新做些设想和想象。希望大家喜欢!

2024-12-19 07:41:20 -

stable diffusion初识_stable diffusion跟其他工具有什么区别]

关于Stable Diffusion的内容很多,在本篇教程里,我会先为你介绍Stable Diffusion模型的运行原理、发展历程和相较于其他AI绘图应用的区别。

2024-12-24 13:45:31 -

PikaAI怎么用_PIkaAI怎样生成视频_AI视频生成器Pika怎么用_AI视频生成工具Pika教程

Pika这款工具7月份在AIGC界横空出世,被圈内誉为目前“全球最好的文本生成视频AI工具”之一,也被认为是另外一款知名AI视频生成工具Runway的强有力挑战者。

2024-12-25 13:35:53 -

如何使用 ChatGPT 调试代码

当您的代码出现问题时,您可以向 ChatGPT 提供故障代码和问题描述。AI 工具将尝试识别并纠正问题。

2024-12-31 12:01:41 -

stable SR脚本安装_stable diffusion脚本网站

上节课我们讲的4xUltraSharp是不是觉得已经很强了! 那么如果我拿出Stable SR脚本你应该如何应对呢?

2024-12-31 13:49:18 -

零基础2天速成!白嫖「秋叶」官方AI绘画课程,卷死同事

和「秋叶」一起学AI绘画,掌握Stable Diffusion、Midjourney的使用方法,开展AI绘画副业,搞钱!?

2024-12-17 12:53:01 -

openpose如何自定义角色_个性化角色姿势怎么定制_Controlnet深度解析

在设计角色姿势时,如何使用openpose进行姿势自定义,以及如何通过拍摄照片或使用第三方后期软件?同时,虚幻引擎对于角色姿势的编辑也很重要,本视频就并展示了如何使用优异商城中的免费资源来创建人物角色。

2024-12-19 11:43:51

![stable diffusion初识_stable diffusion跟其他工具有什么区别]](http://www.aituku.cc/uploadfile/2024/1224/d3a1bbf8bad6e281f82a2168727dfba1.png)